ELK 연동하는 방법을 포스팅하겠습니다.

간단히 설명드리자면

1. Logstash가 파일을 읽어서(모니터링)

2. Elastic Search 인덱스로 전달하고

3. Kibana로 확인

이 순서대로 진행할 것입니다.

Logstash부터 먼저 수정합니다.

도커로 설치했기 때문에 Logstash 컨테이너 안으로 접속합니다.

컨테이너 안으로 접속했으면

/usr/share/logstash/pipeline/lostash.conf 파일을 vi 편집기로 수정합니다.

logstash.conf 파일 내용을 아래와 같이 수정합니다.

파일 내용을 설명드리면

1~5 라인(input)은 Logstash가 읽어 들이는 파일 위치 정보, 즉 InputStream으로 생각하시면 됩니다.

test.txt 파일은 도커 컨테이너 내부에 있거나 컨테이너 외부에 마운트 되어 있어야 합니다.

7~18 라인(output)은 Logstash가 읽은 데이터를 외부로 쓰는 정보, 즉 OutputStream으로 생각하시면 됩니다.

8~11 라인은 Logstash가 데이터를 전달할 Elastic Search 정보이고

13~17 라인은 Logstash가 데이터를 전달하는 로그 정보입니다.

logstash.conf 파일을 어떻게 작성하느냐에 따라 Elastic Search에 전달하는 데이터가 다양하게 전달될 수 있습니다.

(데이터 파싱 가능)

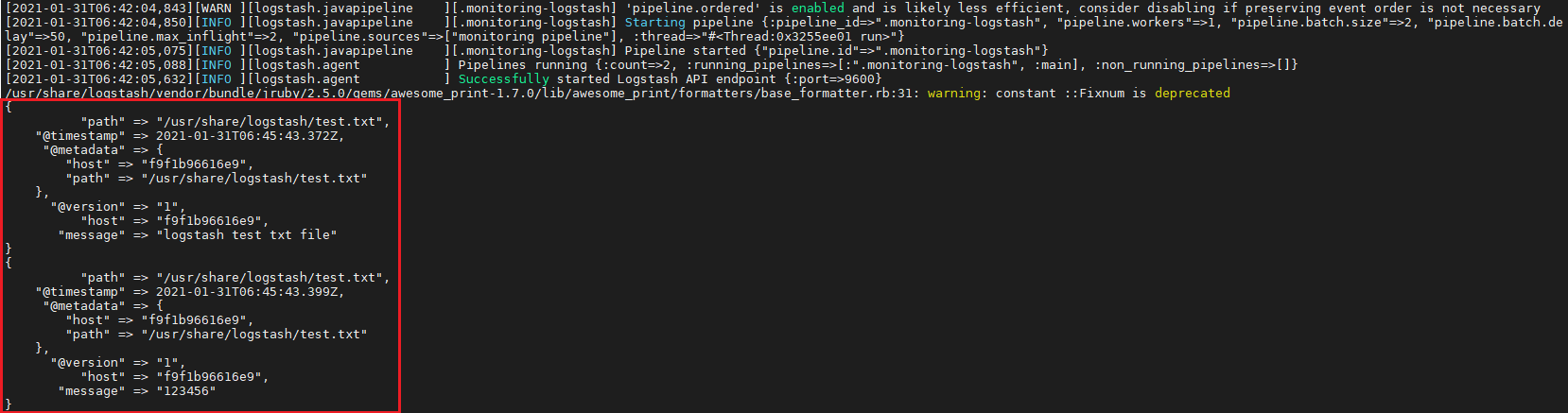

lostash.conf 파일을 수정이 끝났으면 Logstash를 재시작하고 로그를 확인합니다.

위와 같이 test.txt 파일의 내용이 Elastic Search로 전달되었음을 확인할 수 있습니다.

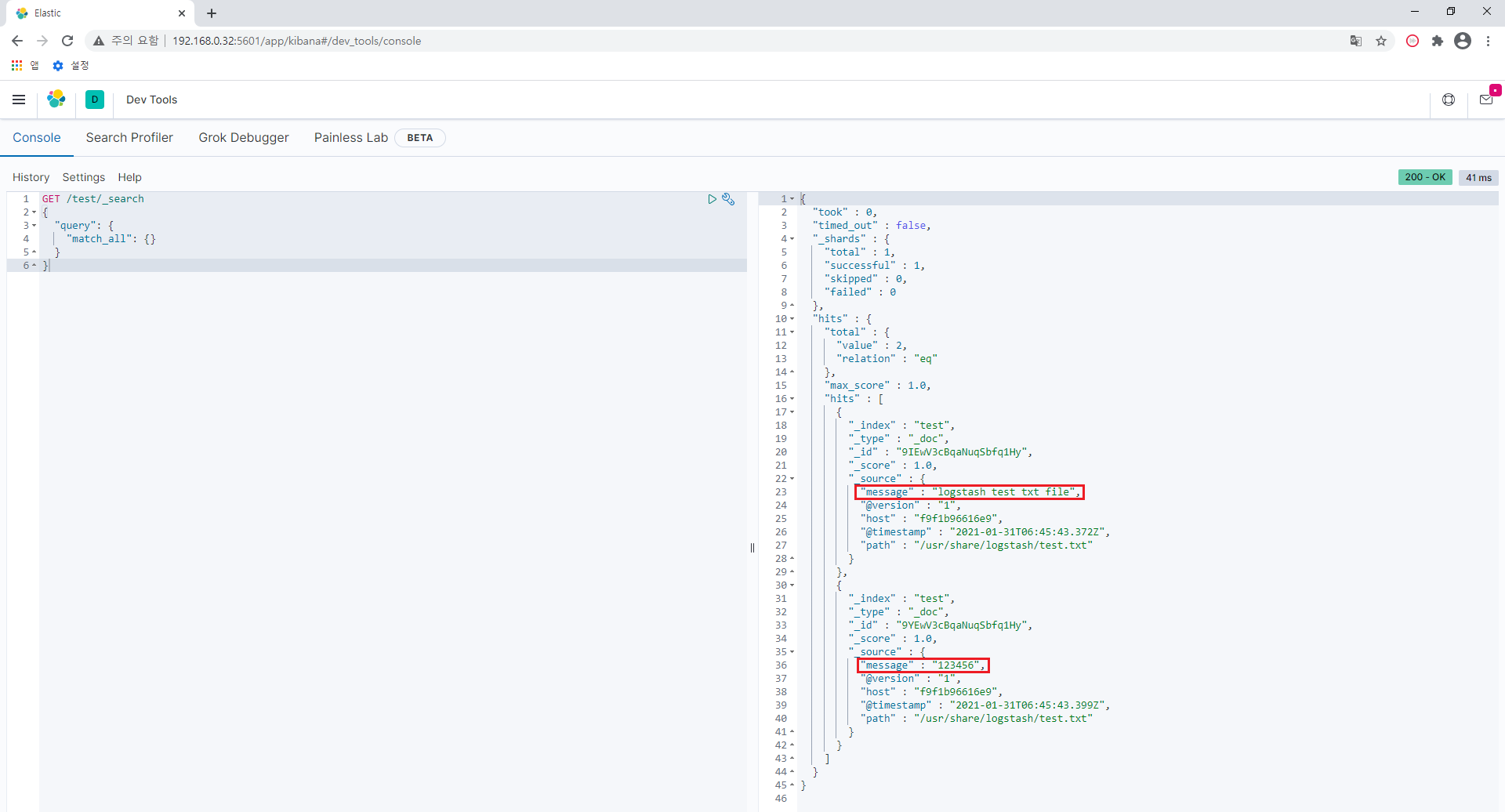

그리고 Kibana로 해당 내용을 확인해보겠습니다.

Kibana로 접속해서 해당 Elastic Search 인덱스를 조회한 결과

test.txt 파일이 전달되었음을 확인했습니다.

Logstash는 단순하게 텍스트 파일뿐만 아니라 다른 여러 종류의 파일, Database, Filebeat를 읽어서

Elastic Search로 전달할 수 있습니다.

다음에 Filebeat 연동 및 logstash.conf 파일에서 데이터 파싱 하는 방법을 포스팅하겠습니다.

'dev > ELK' 카테고리의 다른 글

| Elastic Search 한글 형태소 분석기 플러그인 설치 (0) | 2022.02.06 |

|---|---|

| Elastic Search 파일 첨부 (0) | 2021.10.22 |

| ELK install - Kibana (0) | 2021.01.24 |

| ELK install - Logstash (4) | 2021.01.24 |

| ELK install - Elastic Search (0) | 2021.01.16 |